KI erzeugt realistische 3D-Trainingswelten

Das Wichtigste in Kürze

- Forscher des MIT und des Toyota Research Institute haben eine KI-Methode namens “Steerable Scene Generation” entwickelt.

- Diese Methode erzeugt automatisch realistische, virtuelle 3D-Umgebungen, um Roboter effizienter zu trainieren.

- Sie nutzt ein Diffusionsmodell, das durch intelligente Strategien gesteuert wird, damit physikalisch korrekte und komplexe Szenen entstehen.

- Die KI kann auf Textanweisungen reagieren und so gezielt Trainingsszenarien erstellen, was die Datenerfassung für Robotik-Anwendungen beschleunigt.

- Das Ziel ist es, die Entwicklung von Robotern für den Einsatz im Haushalt oder in der Industrie voranzutreiben.

Die Herausforderung: Realistisches Robotertraining

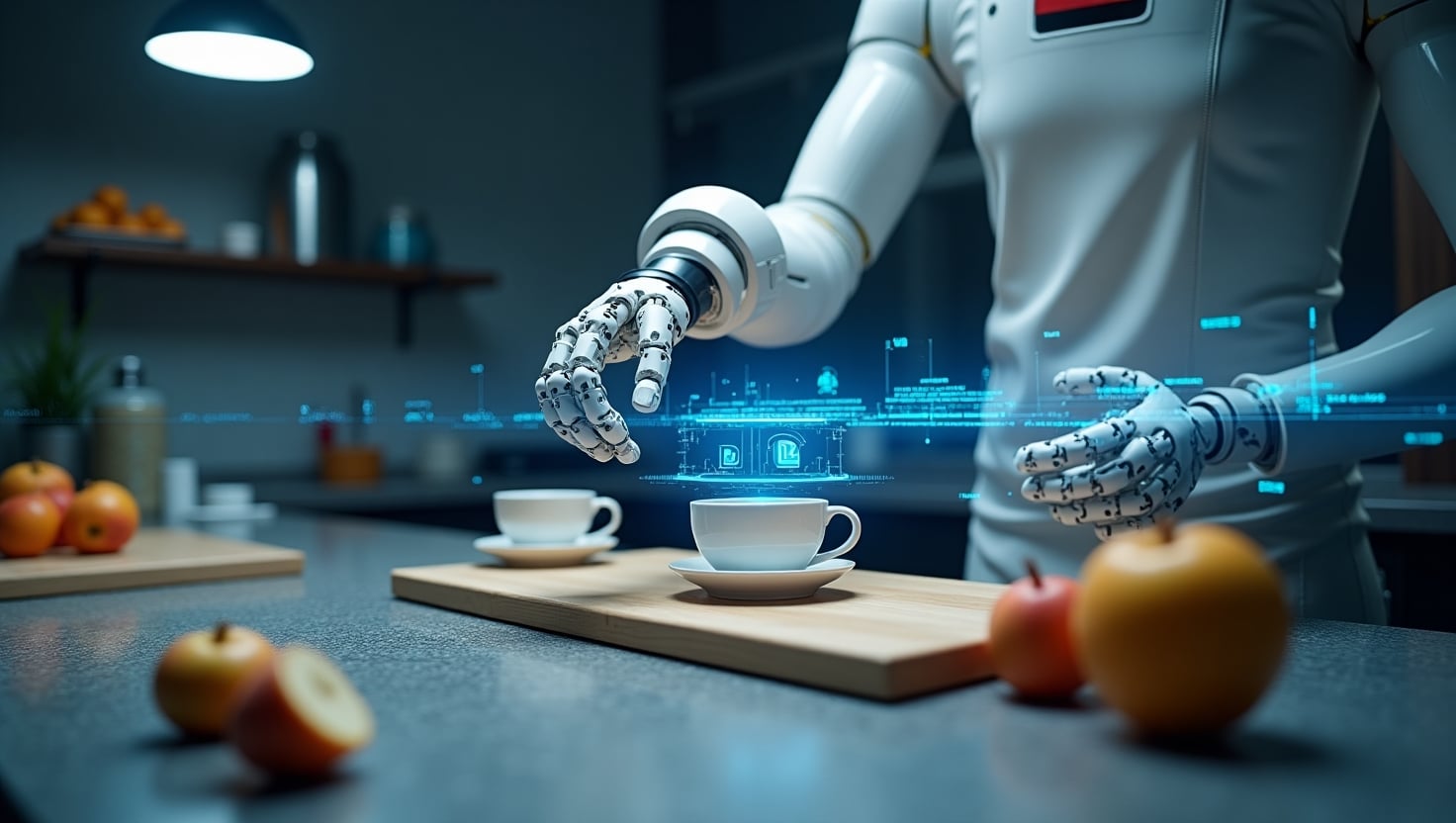

Damit ein Roboter lernt, Objekte zu greifen, zu stapeln oder zu platzieren, benötigt er eine riesige Menge an Trainingsdaten. Diese Daten kann man sich wie eine Sammlung von Anleitungsvideos vorstellen, die jede Bewegung detailliert zeigen. Das Sammeln solcher Demonstrationen mit echten Robotern ist jedoch sehr zeitaufwendig und oft nicht exakt wiederholbar. Eine Alternative ist die Simulation, doch bisherige KI-generierte Umgebungen spiegelten die physikalische Realität oft nur unzureichend wider oder mussten mühsam von Hand erstellt werden.

Steerable Scene Generation: Ein neuer Ansatz

Forscher des MIT Computer Science and Artificial Intelligence Laboratory (CSAIL) und des Toyota Research Institute präsentieren hierfür eine Lösung. Ihre Methode, die “Steerable Scene Generation”, erschafft digitale Szenen wie Küchen oder Wohnzimmer, in denen Roboter realitätsnahe Interaktionen simulieren können. Das System wurde mit über 44 Millionen 3D-Räumen trainiert, die mit Modellen von Alltagsgegenständen gefüllt sind. Es platziert vorhandene 3D-Objekte in neuen Szenen und verfeinert diese anschließend zu einer physikalisch genauen und lebensechten Umgebung.

Die Erstellung dieser 3D-Welten basiert auf einem sogenannten Diffusionsmodell. Du kannst dir das so vorstellen: Die KI startet mit zufälligem Rauschen, ähnlich wie bei einem alten Fernsehbild, und formt daraus schrittweise ein detailliertes Bild. Dieser Prozess wird gezielt in eine Richtung “gelenkt”, sodass am Ende eine plausible Szene entsteht. Dabei achtet das System darauf, dass physikalische Fehler vermieden werden. Ein bekanntes Problem in 3D-Grafiken ist das “Clipping”, bei dem sich Modelle überlappen oder durchdringen. Die Methode stellt beispielsweise sicher, dass eine Gabel nicht durch eine Schüssel auf dem Tisch hindurchragt.

Intelligente Strategien für komplexe Szenarien

Um die Erstellung der Szenen zu optimieren, werden verschiedene Strategien genutzt. Eine zentrale Methode ist die “Monte-Carlo-Baumsuche” (MCTS). Hierbei erstellt das Modell eine Reihe alternativer Szenen und entwickelt sie schrittweise weiter, um ein bestimmtes Ziel zu erreichen. Dieses Ziel kann zum Beispiel eine möglichst hohe physikalische Genauigkeit oder eine maximale Anzahl an Objekten sein. Ein ähnliches Verfahren nutzt auch das bekannte KI-Programm AlphaGo, um menschliche Gegner im Brettspiel Go zu besiegen, indem es mögliche Züge vorausschauend bewertet.

In einem Experiment konnte die MCTS-Methode eine Restaurantszene mit bis zu 34 Objekten auf einem Tisch erstellen, obwohl das Modell nur mit Szenen trainiert wurde, die im Durchschnitt 17 Objekte enthielten. Dies zeigt, dass die KI komplexere Szenarien generieren kann, als sie in ihren Trainingsdaten gesehen hat.

Zusätzlich ermöglicht das System, Trainingsszenarien durch Reinforcement Learning zu erstellen. Dabei lernt das Diffusionsmodell durch Versuch und Irrtum, ein bestimmtes Ziel zu erfüllen. Man definiert eine Belohnung für ein gewünschtes Ergebnis, woraufhin das Modell automatisch lernt, Szenen mit höheren Punktzahlen zu erzeugen. Außerdem können Nutzer das System direkt über Texteingaben steuern, etwa mit der Anweisung “eine Küche mit vier Äpfeln und einer Schüssel auf dem Tisch”. Die Methode setzte solche Anweisungen mit einer hohen Genauigkeit von bis zu 98 Prozent um, was eine deutliche Verbesserung gegenüber vergleichbaren Ansätzen darstellt.

Bedeutung für die zukünftige Robotik

Die Stärke des Projekts liegt in seiner Fähigkeit, eine große Anzahl an nützlichen Szenen für die Robotik zu erstellen. Diese virtuellen Testumgebungen ermöglichen es, einen Roboter bei der Interaktion mit verschiedenen Gegenständen aufzuzeichnen. So kann er beispielsweise lernen, Besteck in einen Halter zu sortieren oder Brotscheiben auf Tellern neu anzuordnen. Jede Simulation wirkt dabei flüssig und realistisch, was eine wichtige Voraussetzung dafür ist, dass die erlernten Fähigkeiten später auf echte Roboter übertragen werden können.

Zukunftsaussichten und Weiterentwicklung

Die Forscher betrachten ihre Arbeit als einen wichtigen Machbarkeitsbeweis. Zukünftig soll die generative KI nicht nur vorhandene Objekte anordnen, sondern auch völlig neue Objekte und Szenen erschaffen. Geplant ist zudem die Integration von beweglichen Objekten wie Schränken oder Gläsern, um die Interaktivität der Szenen weiter zu erhöhen. Durch die Erweiterung der Vielfalt und des Realismus der KI-generierten Testumgebungen hofft das Team, eine Community aufzubauen, die eine riesige Datenmenge erstellt. Diese könnte als Grundlage dienen, um Robotern komplexe Fähigkeiten beizubringen.

Unsere Einschätzung

Die “Steerable Scene Generation” adressiert einen zentralen Engpass in der modernen Robotik: die effiziente Erstellung von qualitativ hochwertigen und vielfältigen Trainingsdaten. Die Kombination eines Diffusionsmodells mit intelligenten Suchstrategien wie der Monte-Carlo-Baumsuche ist ein vielversprechender Ansatz, um die Grenzen bisheriger Simulationsumgebungen zu überwinden. Obwohl sich die Technologie noch in der Entwicklung befindet, hat sie das Potenzial, das Training von Robotern grundlegend zu verändern. Indem sie die Datengenerierung automatisiert und verbessert, könnte sie die Entwicklung vielseitiger Roboter für den Einsatz in Industrie und Alltag erheblich beschleunigen.

Quellen

- MIT News: Den Originalartikel findest du hier.